Blog

flink-03 集群安装

集群部署

| 节点服务器 | hadoop101 | hadoop102 | hadoop103 |

| 角色 | JobManagerTaskManager | TaskManager | TaskManager |

具体安装步骤:

- 下载解压安装包

- 同上步骤

- 修改集群配置文件

指定haoop101为jobmanager节点

# Jobmanager

jobmanager.rpc.address: hadoop101

jobmanager.bind-host: 0.0.0.0

rest.address: hadoop101

rest.bind-address: 0.0.0.0

# TaskManager

taskmanager.host: hadoop101

taskmanager.bind-host: 0.0.0.0修改workers文件,将另外两台节点服务器添加为flink集群的taskmanager节点

# vim conf/workers

hadoop101

hadoop102

hadoop103指定master配置文件信息

# vim conf/master

hadoop101:8081分发文件

# 修改 flink-conf.yaml中TaskManager地址

# hadoop102

taskmanager.host: hadoop102

# hadoop103

taskmanager.host: hadoop103- 启动集群

- hadoop101 jobmanager节点执行

bin/start-cluster.shflink-conf.yaml参数说明

- jobmanager.memory.process.size

- 对jobmanager进程可使用的全部内存进行配置,包括JVM元空间和其他开销 默认1600M,可以根据集群规模进行适当调整

- taskmanager.memory.process.size

- 对TaskManager进程可以使用到的全部内存进行配置,包括JVM元空间和其他开销 默认1728M,可以根据集群规模进行适当调整

- taskmanager.numberOfTaskSlots

- 对每个TaskManager能够分配的Slot数量进行配置,默认为1,可以根据TaskManager所在的机器能够供给Flink的CPU数量决定

- 所谓Slot就是TaskManager中具体运行一个任务所分配的计算资源

- parallelism.default

- Flink任务执行的并行度,默认为1,优先级低于代码中进行的并行度配置和任务提交时使用参数指定的并行度数量

测试集群 打包wordcount上传即可

- 生产环境有的包使用provided 过滤

- 使用maven-shade-plugin插件打包

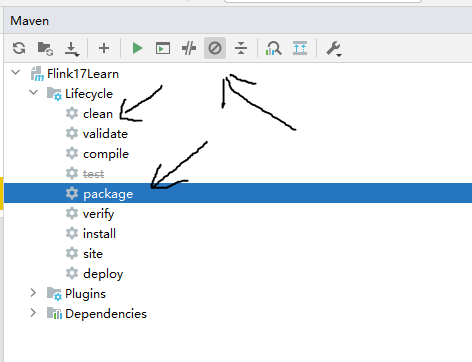

- 打包的时候务必 先 clean 再 package

使用终端提交任务

/data/flink/bin/flink run -m hadoop101:8081 -c com.learn.wc.WordCountStreamDemo /root/flink-jobs/Flink17Learn-1.0-SNAPSHOT.jar-m 指定配置文件中rest地址 也就是master地址