Blog

hadoop-06 hdfs api操作

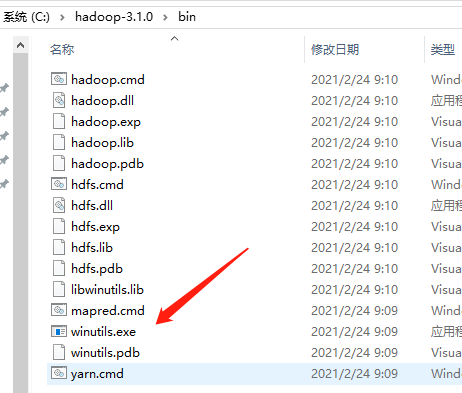

windows环境依赖

同时设置环境变量 c:\hadoop-3.1.0\bin添加到path

Idea创建maven项目

pom.xml

<dependencies>

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.1.3</version>

</dependency>

<dependency>

<groupId>junit</groupId>

<artifactId>junit</artifactId>

<version>4.13</version>

</dependency>

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.30</version>

</dependency>

</dependencies>配置log4j.properties

log4j.rootLogger=INFO, stdout

log4j.appender.stdout=org.apache.log4j.ConsoleAppender

log4j.appender.stdout.layout=org.apache.log4j.PatternLayout

log4j.appender.stdout.layout.ConversionPattern=%d %p [%c] - %m%n

log4j.appender.logfile=org.apache.log4j.FileAppender

log4j.appender.logfile.File=target/spring.log

log4j.appender.logfile.layout=org.apache.log4j.PatternLayout

log4j.appender.logfile.layout.ConversionPattern=%d %p [%c] - %m%nHdfsClient 示例:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.*;

import org.junit.After;

import org.junit.Before;

import org.junit.Test;

import java.io.IOException;

import java.net.URI;

import java.net.URISyntaxException;

import java.util.Arrays;

/**

* 客户端代码常用套路

* 1.获取一个客户端对象

* 2.执行相关操作命令

* 3.关闭资源

* HDFS Zookeeper

*/

public class HdfsClient {

private FileSystem fs;

@Before

public void init() throws URISyntaxException, IOException, InterruptedException {

// 连接集群NameNode地址

URI uri = new URI("hdfs://hadoop102:8020");

// 创建配置文件

Configuration configuration = new Configuration();

// 配置文件中设置副本数

configuration.set("dfs.replication", "2");

// 操作HDFS用户

String user="atguigu";

// 获取客户端对象 ctrl alt + F 创建全局变量

fs = FileSystem.get(uri, configuration, user);

}

@After

public void close() throws IOException {

// 关闭资源

fs.close();

}

// 创建目录

@Test

public void testmkdir() throws URISyntaxException, IOException, InterruptedException {

// 创建一个文件夹操作

fs.mkdirs(new Path("/xiyou/huaguoshan1"));

}

// 上传文件

/**

* 参数优先级

* hdfs-default.xml < hdfs-site.xml < 项目中resource/hdfs-site.xml < 代码中配置

* @throws IOException

*/

@Test

public void testPut() throws IOException {

// 参数解读:

// 参数1 表示删除原数据

// 参数2 是否允许覆盖

// 参数3 原数据路径

// 参数4 目的地路径

fs.copyFromLocalFile(false, true, new Path("E:\\sunwukong.txt"), new Path("/xiyou/huaguoshan/"));

}

// 文件下载

@Test

public void testGet() throws IOException {

// 参数解读

// 参数1 原文件是否删除

// 参数2 原文件路径HDFS

// 参数3 目标地址路径win

// 参数4 是否文件校验

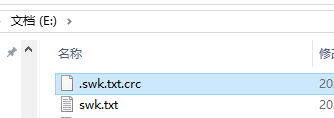

fs.copyToLocalFile(false, new Path("/xiyou/huaguoshan/sunwukong.txt"), new Path("E:\\swk.txt"), false);

}

// 删除文件

@Test

public void testRm() throws IOException {

// 参数解读

// 参数1 要删除的路径

// 参数2 是否递归删除

//fs.delete(new Path("/xiyou/huaguoshan/sunwukong.txt"), true);

// 删除空目录

//fs.delete(new Path("/xiyou/huaguoshan"), false);

// 删除非空目录 参数2 需为true

fs.delete(new Path("/xiyou"), true);

}

// 文件更名和移动

@Test

public void testMv() throws IOException {

// 参数解读

// 参数1 原文件路径

// 参数2 目标文件路径

//fs.rename(new Path("/input/words.txt"), new Path("/input/word.txt"));

// 文件的移动和更名

//fs.rename(new Path("/input/word.txt"), new Path("/words.txt"));

// 目录的更名

fs.rename(new Path("/input"), new Path("/output"));

}

// 获取文件详情信息

@Test

public void fileDetail() throws IOException {

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/sanguo"), true);

while (listFiles.hasNext()){

LocatedFileStatus fileStatus = listFiles.next();

System.out.println("==========" + fileStatus.getPath() + "==========");

// 获取文件权限信息

System.out.println(fileStatus.getPermission());

// 获取文件用户

System.out.println(fileStatus.getOwner());

// 获取文件权限组

System.out.println(fileStatus.getGroup());

// 获取文件大小

System.out.println(fileStatus.getLen());

// 获取最后修改时间

System.out.println(fileStatus.getModificationTime());

// 获取副本数

System.out.println(fileStatus.getReplication());

// 获取块大小 128M默认

System.out.println(fileStatus.getBlockSize());

// 获取文件名称

System.out.println(fileStatus.getPath().getName());

// 读取块存储位置信息

System.out.println(Arrays.toString(fileStatus.getBlockLocations()));

}

}

// 文件和文件夹判断

@Test

public void testFile() throws IOException {

FileStatus[] listStatus = fs.listStatus(new Path("/sanguo"));

for (FileStatus status : listStatus) {

if (status.isFile()) {

System.out.println("这是一个文件: " + status.getPath().getName());

} else {

System.out.println("这是一个目录: " + status.getPath().getName());

}

}

}

}idea项目中resource/hdfs-site.xml

<?xml version="1.0" encoding="UTF-8" ?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl" ?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

.crc文件用于下载hdfs文件到本地校验